Il settore industriale dello spazio è uno dei mercati che più sta crescendo. Per dare un’idea delle dimensioni del fenomeno: la “new space economy”, nei prossimi anni, è destinata a crescere a un ritmo superiore all’8% annuo, proiettandosi entro il 2030 verso valori che potrebbero superare persino quelli dell’industria automobilistica, oggi la più imponente al mondo.

Per sostenere una crescita così rapida, è necessario aumentare significativamente la capacità computazionale e di automazione nelle applicazioni spaziali. Ed è qui che entra in gioco l’intelligenza artificiale.

L’integrazione dell’AI nelle applicazioni spaziali rappresenta una sfida affascinante, ma anche un passaggio cruciale: permetterà, ad esempio, di esplorare in modo più efficiente altri pianeti, automatizzare manovre complesse come l’attracco spaziale (docking), e analizzare più rapidamente i dati ambientali, preziosi per comprendere l’evoluzione del nostro pianeta. Al giorno d’oggi infatti il problema principale è la latenza nelle comunicazioni: per inviare un segnale da Terra a Marte possono volerci dai 6 ai 20 minuti, a seconda della posizione dei pianeti. Questo significa che, controllando remotamente un robot come Perseverance, ogni azione può richiedere fino a 40 minuti per essere comandata e confermata.

Inoltre, strumenti come telescopi spaziali (si pensi al James Webb) e sonde planetarie inviano a Terra la bitmap completa di ogni immagine che poi viene processata e analizzata, il che é incredibilmente inefficiente in termini di consumo energetico e banda trasmissiva. Dotare i satelliti di maggiore potenza di calcolo e algoritmi intelligenti permetterebbe di risolvere questi problemi, riducendo drasticamente costi e tempi.

Il nemico invisibile: la radiazione cosmica

Portare l’intelligenza artificiale nello spazio non è affatto semplice. Innanzitutto, l’ambiente extraterrestre è estremamente ostile: senza la protezione dell’atmosfera e del campo magnetico terrestre, i componenti elettronici (così come gli esseri umani) sono esposti ad una quantità enorme di radiazioni (i raggi cosmici). Per dare un’idea: in un viaggio di andata e ritorno su Marte, circa la metà delle cellule del corpo umano verrebbe danneggiata o distrutta dalla radiazione. Purtroppo l’elettronica é ancora più fragile del corpo umano e l’esposizione ai raggi cosmici fa sì che il calcolo svolto risulti sbagliato.

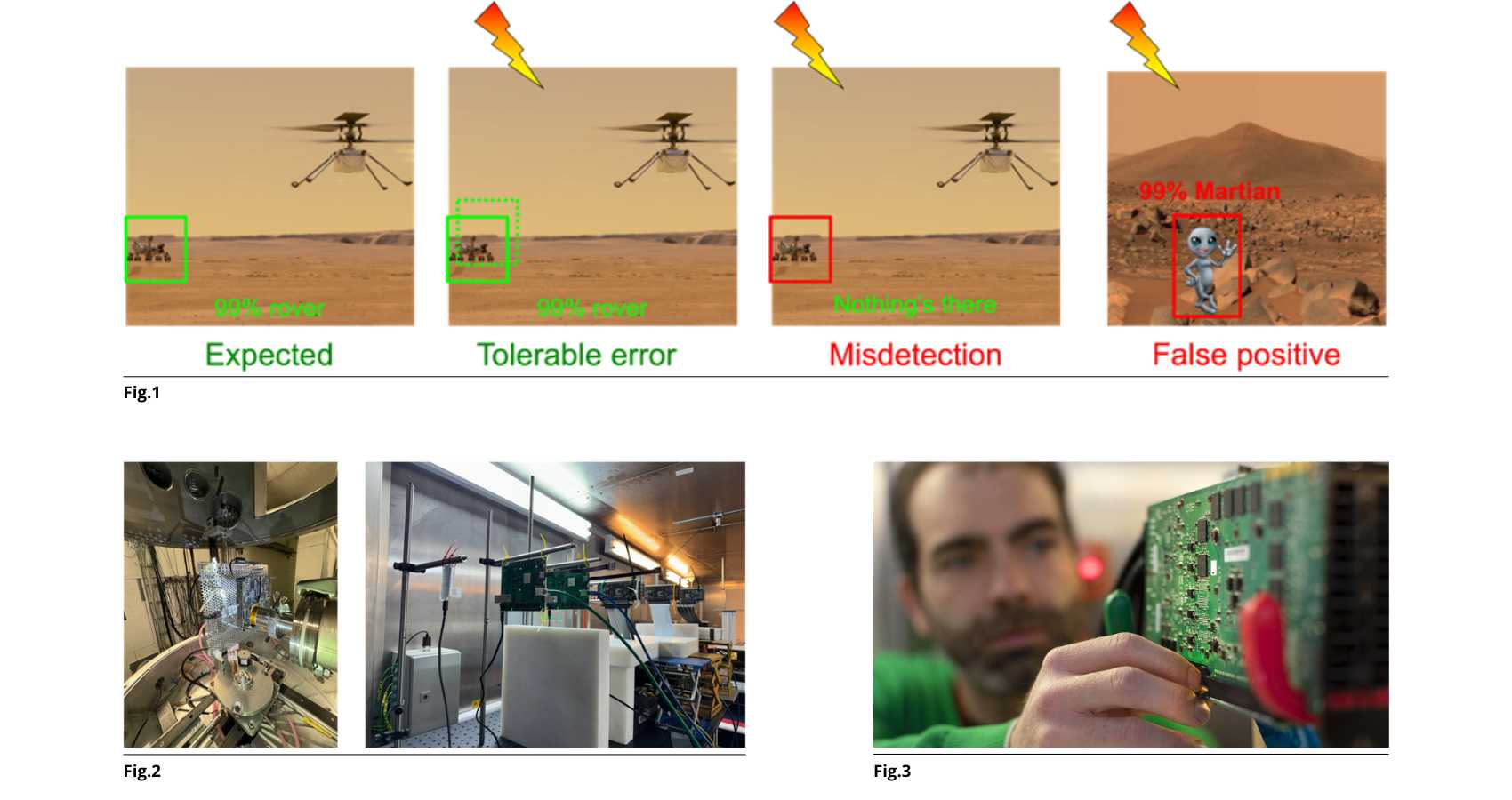

Il problema più serio? Gli effetti delle radiazioni non lasciano tracce evidenti e quindi una rete neurale potrebbe compiere un calcolo errato senza accorgersene e, di conseguenza, prendere decisioni sbagliate con potenziali effetti catastrofici: riconoscere ostacoli che non esistono, ignorarne di reali, oppure fallire un’operazione di attracco. Schermare completamente un dispositivo sarebbe come ricreare l’intera atmosfera terrestre intorno a una sonda, un’impresa improponibile. D’altra parte, costruire hardware che siano resistenti ai raggi cosmici è estremamente costoso e poco scalabile.

La sfida: rendere l’AI resistente allo spazio

Proprio per affrontare questi limiti, al Dipartimento di Ingegneria Industriale stiamo lavorando in collaborazione con agenzie spaziali e aziende leader del settore per comprendere come la radiazione possa modificare la predizione delle reti neurali. L’obiettivo è chiaro: applicare delle modifiche all’algoritmo per fare in modo che, in caso di errore, il sistema non faccia azioni pericolose ma riesca a gestire autonomamente l’effetto della radiazione.

Una parte fondamentale del nostro lavoro consiste nel simulare la radiazione cosmica in laboratorio. Per farlo utilizziamo acceleratori di particelle – come ChipIR nel Regno Unito, RADEF in Finlandia, UCL in Belgio e il TIFPA a Trento – che in pochi secondi colpiscono i dispositivi elettronici con fasci di protoni, ioni pesanti e neutroni, fornendo una statistica molto accurata di come l’applicazione possa sbagliare per colpa dell’esposizione a radiazione.

Testiamo diversi tipi di componenti: GPU, TPU, FPGA e acceleratori dedicati, eseguendo reti neurali in tempo reale durante l’esposizione. Identifichiamo poi le modifiche al calcolo che la radiazione crea per poi inserire delle parti di codice dedicato per impedire che questi errori di calcolo si propaghino. Inoltre, ri-addestriamo le reti neurali per insegnare loro a riconoscere e correggere questi comportamenti anomali.

I risultati finora sono molto promettenti: siamo riusciti a correggere fino al 90% degli errori, con un impatto minimo sulle prestazioni (meno del 2% di overhead), aumentando la capacità computazionale a bordo dei satelliti di ben sei ordini di grandezza.

Uno sguardo al futuro

L’obiettivo finale è chiaro: rendere possibile un uso diffuso e sicuro dell’intelligenza artificiale nello spazio. I prossimi passi riguarderanno l’integrazione di sistemi robotici intelligenti a bordo di sonde e satelliti, garantendo l’affidabilità del sistema ma anche la creazione di un framework di guida autonoma che si adatti all’ambiente ostile dei pianeti.

Lo spazio non sarà più solo una destinazione: diventerà un ambiente operativo, dove l’AI non sarà un optional, ma una necessità.

Figura 1: esempio di errori causati da radiazione

Figura 2: setup sperimentale negli acceleratori di particelle

Figura 3: durante un esperimento (credits ChipIR – STFC)