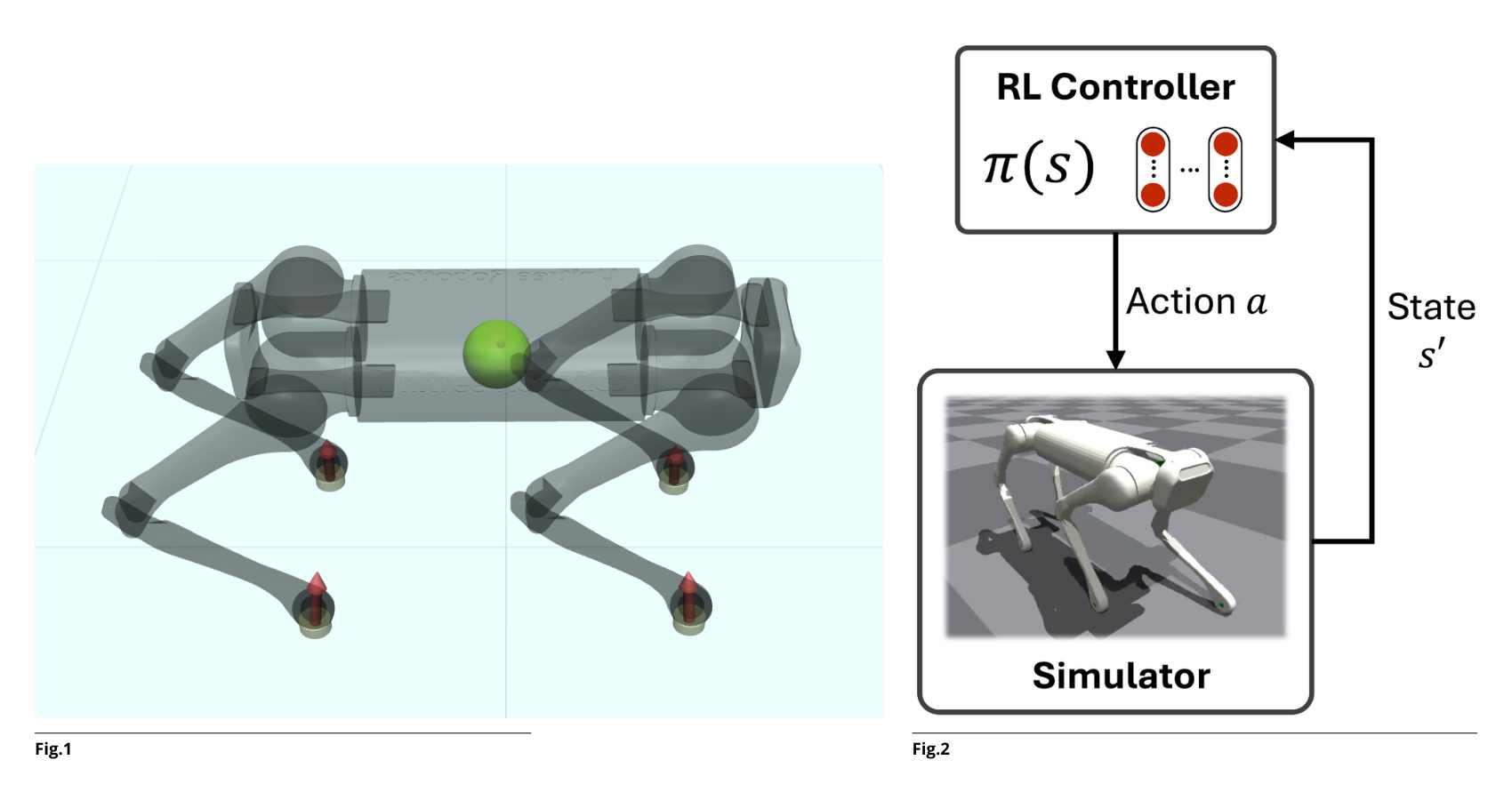

Far camminare un robot quadrupede non è solo una questione di movimento, ma di equilibrio dinamico. La sfida per i ricercatori del DII è stata addestrare il robot Unitree Aliengo a muoversi in modo fluido, rispettando rigorosi vincoli fisici e cinematici. Per farlo, il team ha utilizzato il Reinforcement Learning (RL), ma con un tocco innovativo: invece di limitarsi agli algoritmi standard, hanno sviluppato una variante “custom” capace di dare priorità alla sicurezza del sistema. Il cuore tecnologico del progetto risiede nell’ottimizzazione dell’algoritmo Proximal Policy Optimization (PPO). Mentre i metodi tradizionali penalizzano gli errori (come una caduta o un urto) semplicemente sottraendo punti al punteggio del robot, la soluzione utilizzata introduce un discount factor γ adattivo (Fig.1).

PPO è un algoritmo di Reinforcement Learning appartenente alla famiglia dei metodi policy gradient, che ottimizza iterativamente la policy πθ limitando la differenza tra policy successiva e precedente tramite un meccanismo di clipping, questo per migliorare la stabilità dell’addestramento. Nel caso dei robot quadrupedi, le principali violazioni dei vincoli possono riguardare superamento dei limiti cinematici, velocità o accelerazioni al di fuori dei limiti operativi, contatti non corretti con il terreno, perdita di equilibrio o cadute, e deviazioni rispetto allo stile di camminata desiderato (Fig.2).

Nei metodi tradizionali di RL, queste violazioni vengono gestite tramite penalizzazioni direttamente nel reward. La nostra variante, basata sul progetto Constraints as Terminations, introduce invece un discount factor adattivo, modulato in funzione della gravità della violazione. In questo modo, quando il comportamento del robot si discosta in modo significativo dai vincoli imposti, il peso delle ricompense future viene ridotto, favorendo l’apprendimento di camminate più sicure, stabili ed energeticamente efficienti. Questo è il Constrained Reinforcement Learning.

Il successo del trasferimento della “mente” digitale del robot sul corpo fisico è stato garantito da un rigoroso processo di validazione:

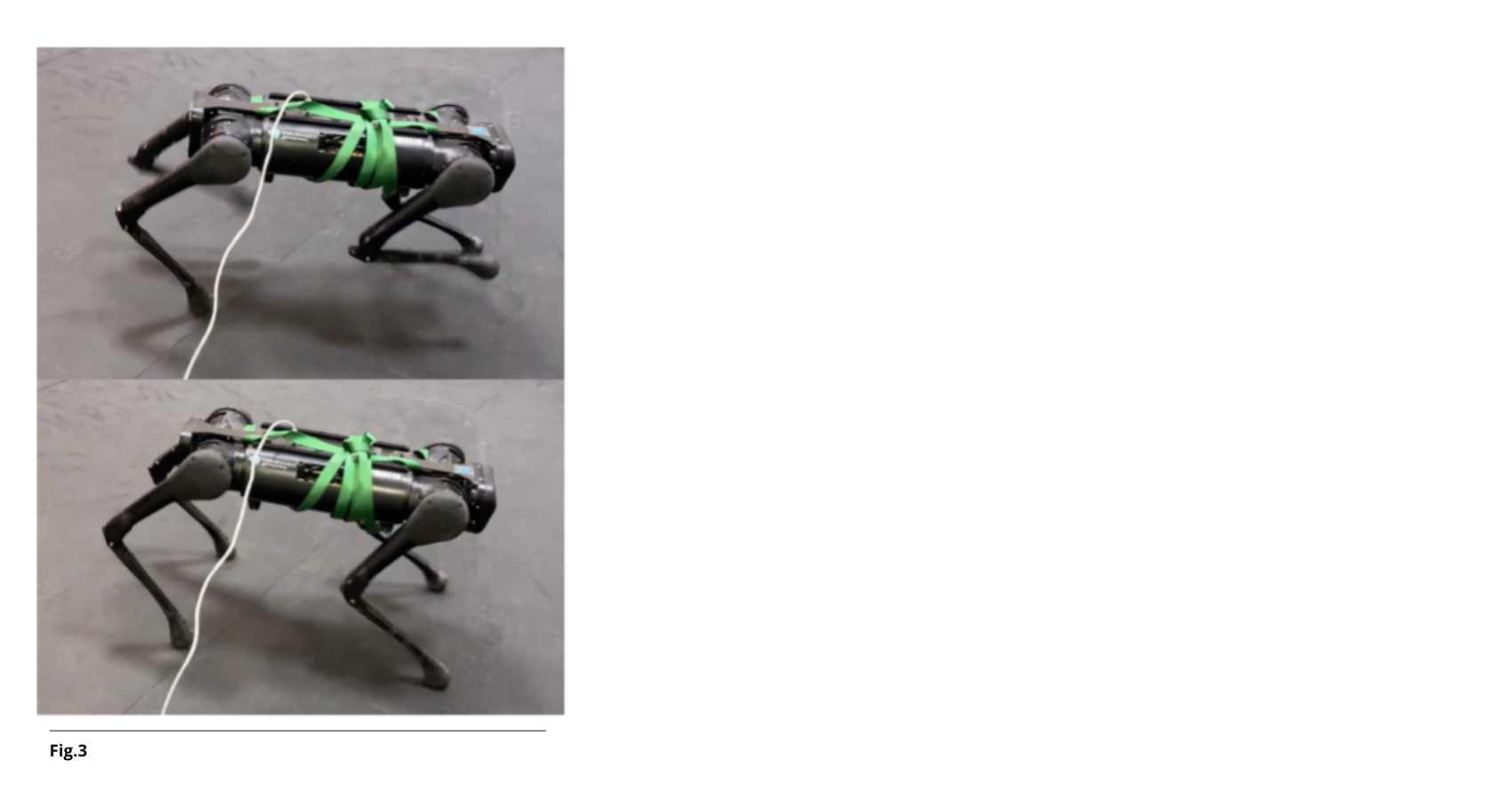

I risultati ottenuti a Trento non sono che l’inizio (Fig.3). Il futuro della ricerca si sposterà su terreni ancora più impervi e verso la loco-manipolazione: l’integrazione di bracci robotici sui quadrupedi per permettere loro non solo di esplorare, ma di interagire attivamente con l’ambiente in scenari di logistica e soccorso.

Fig. 1: modello Mujoco Unitree Aliengo

Fig.2: schema di controllo Policy RL

Fig. 3: robot Unitree Aliengo